Principais destaques:

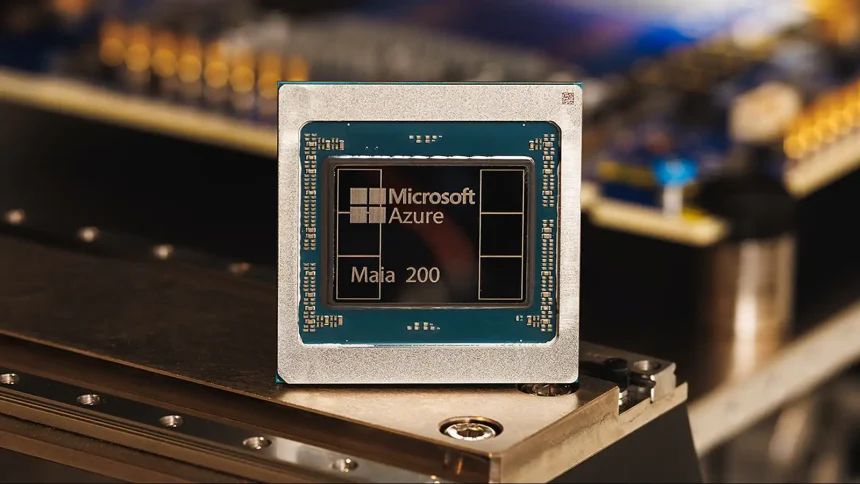

- O Maia 200 é o novo chip de inferência em inteligência artificial da Microsoft, integrado à infraestrutura de nuvem.

- Segundo a empresa, o acelerador entrega desempenho superior aos chips de IA do Google e da Amazon em cenários específicos.

- A novidade promete mais eficiência energética, menor custo por desempenho e ganhos diretos para serviços como Copilot e aplicações baseadas em grandes modelos de linguagem.

A Microsoft apresentou oficialmente o Maia 200, seu chip mais avançado para inferência em inteligência artificial.

Diferentemente de aceleradores voltados ao treinamento de modelos, o novo hardware foi projetado para executar previsões, gerar respostas e processar dados em tempo real, tarefas centrais para sistemas de IA usados no dia a dia corporativo.

De acordo com a empresa, o Maia 200 já está sendo integrado à infraestrutura do Azure e deve ampliar a capacidade de serviços internos antes de chegar a outros clientes da nuvem.

Foco total em inferência e eficiência

O Maia 200 alcança mais de 10 petaflops de desempenho usando precisão FP4, um formato de dados altamente comprimido que prioriza velocidade e eficiência energética.

Em FP8, mais preciso, o chip entrega cerca de 5 petaflops. Na prática, isso significa que um único nó equipado com o Maia 200 consegue rodar modelos de grande porte com margem para crescer no futuro.

Segundo a Microsoft, esse desempenho representa até três vezes mais capacidade em FP4 do que a terceira geração do Amazon Trainium e resultados superiores aos da sétima geração da TPU do Google em FP8.

O foco em inferência reforça a estratégia da empresa de otimizar custos e consumo energético em ambientes de produção.

Tecnologia de ponta e menor custo por desempenho

Um dos diferenciais do Maia 200 está no processo de fabricação. O chip utiliza litografia de 3 nanômetros, produzida pela TSMC, reunindo cerca de 100 bilhões de transistores em uma única peça.

Esse avanço permite, segundo a Microsoft, até 30% mais desempenho por dólar em comparação com sistemas anteriores.

Além disso, o chip traz um sistema de memória pensado para manter pesos e dados dos modelos o mais próximo possível do processamento, reduzindo a necessidade de hardware adicional e facilitando a integração em data centers já existentes.

Impacto direto em serviços e aplicações de IA

Embora o Maia 200 não seja voltado ao consumidor final, seus efeitos devem ser sentidos indiretamente.

Ferramentas como o Copilot e aplicações que utilizam modelos como o GPT-4 tendem a ganhar respostas mais rápidas e maior capacidade de processamento.

Para desenvolvedores, cientistas e empresas que usam IA em larga escala, o novo chip pode acelerar projetos complexos, desde pesquisas científicas até simulações avançadas de clima, biologia e química.

A Microsoft já sinalizou que, no futuro, o Maia 200 terá disponibilidade mais ampla para clientes do Azure, ampliando o alcance dessa nova geração de hardware de IA.