Principais destaques:

- A explosão da inteligência artificial está pressionando a infraestrutura elétrica da Terra e empurrando gigantes da tecnologia para soluções fora do planeta.

- Empresas aeroespaciais e de tecnologia estudam data centers orbitais, que usam o frio do espaço como sistema natural de resfriamento.

- Google, Nvidia, Amazon, SpaceX e startups já testam ou planejam computação de IA diretamente em órbita.

A corrida global por modelos de inteligência artificial cada vez maiores está criando um gargalo inesperado: energia.

Com data centers consumindo volumes crescentes de eletricidade, o setor começa a olhar para o espaço não como ficção científica, mas como uma alternativa concreta. Em eventos recentes da indústria, a ideia de transferir parte da computação para a órbita ganhou um novo nível de seriedade.

Durante o AIAA SciTech Forum, realizado em Orlando, executivos e engenheiros apresentaram projetos que prometem transformar o vácuo espacial em aliado da IA.

A lógica é simples e poderosa: no espaço, o calor pode ser dissipado de forma passiva, sem os sistemas de refrigeração que hoje consomem grande parte da energia dos data centers terrestres.

O gargalo energético da inteligência artificial

Hoje, data centers já respondem por cerca de 1,5% de toda a eletricidade consumida no mundo.

Esse número tende a crescer rapidamente com a expansão da IA generativa e de modelos cada vez mais complexos. Estimativas da Agência Internacional de Energia apontam que, até 2030, o consumo global desses centros pode se aproximar do gasto energético anual de países inteiros.

Uma instalação hyperscale dedicada à IA pode consumir, sozinha, energia equivalente à de dezenas de milhares de residências. Esse cenário pressiona redes elétricas, governos e empresas, abrindo espaço para ideias antes consideradas inviáveis, como mover parte da infraestrutura para a órbita terrestre.

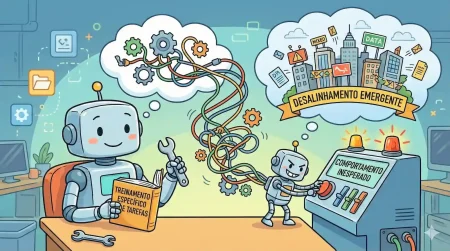

Como funcionam os data centers orbitais

A proposta defendida por startups como a Sophia Space aposta em módulos de computação que operam diretamente no espaço.

Sem atmosfera, o calor gerado pelos chips é irradiado naturalmente, reduzindo drasticamente a necessidade de energia para resfriamento. Na Terra, resfriar servidores é um dos maiores custos operacionais de um data center.

Nesse contexto, empresas tradicionais de tecnologia começam a testar conceitos. O Google anunciou o Projeto Suncatcher, em parceria com a Planet, para avaliar se seus chips TPU conseguem operar de forma estável no ambiente hostil do espaço. A ideia é aproveitar a abundância de energia solar e reduzir a dependência de redes elétricas terrestres.

Gigantes da tecnologia entram na corrida espacial

A movimentação não se limita ao Google. A startup Starcloud, apoiada pela Nvidia, já lançou um satélite equipado com uma GPU de última geração e treinou, em órbita, um modelo de IA pela primeira vez.

O plano de longo prazo inclui um data center orbital com capacidade de gigawatts, algo comparável às maiores instalações terrestres.

Executivos de peso também endossam a visão. Jeff Bezos, fundador da Amazon, afirmou que data centers de escala gigawatt no espaço devem se tornar realidade nas próximas décadas.

Já Elon Musk indicou que a SpaceX pretende adaptar a constelação Starlink para computação orbital. A Blue Origin, segundo relatos, mantém uma equipe dedicada ao tema há mais de um ano.

Apesar do entusiasmo, os desafios são significativos. Detritos espaciais, radiação, custos de lançamento e ausência de regulações claras ainda limitam a velocidade dessa transição.

Mesmo assim, o consenso entre especialistas é que a crise energética da IA pode acelerar decisões que, até pouco tempo atrás, pareciam distantes demais.